DeepSeek обвалив ринок: чому китайський ШІ виявився в 30 разів ефективнішим за GPT-4

Наприкінці січня маловідомий китайський стартап DeepSeek опинився в центрі уваги світових ЗМІ. Скромні інвестиції в $5,6 млн у розробку нової моделі обернулися нищівним ударом по ринку — американські техногіганти в сукупності втратили майже $1 трлн капіталізації.

Поява доступного аналога ChatGPT, що претендує на звання «вбивці Кремнієвої долини», викликала справжній переполох в індустрії. ForkLog розповідає, звідки взялася компанія DeepSeek, як вона домоглася успіху і що чекає на світовий ринок мовних моделей.

Історія сходження DeepSeek

DeepSeek почала самостійний шлях у травні 2023 року в Ханчжоу — столиці провінції Чжецзян. Це місто вважається найбільшим у Китаї центром електронної комерції, де розташовуються штаб-квартири гігантів на кшталт Alibaba Group, Geely, Hikvision і Ant Group.

За проєктом стоїть Лян Веньфен — підприємець і співзасновник хедж-фонду High-Flyer, що управляє активами в розмірі $8 млрд. Заснована 2015 року компанія давно виявляла інтерес до машинного навчання, інвестуючи значні кошти у створення власної обчислювальної інфраструктури, а також у дослідження в галузі штучного інтелекту. Саме з її структури виникла DeepSeek.

2020 року High-Flyer представила суперкомп’ютер Fire-Flyer I вартістю 200 млн юанів ($27,6 млн), що спеціалізується на глибокому навчанні ШІ. Роком пізніше з’явився Fire-Flyer II — система за 1 млрд юанів ($138 млн), оснащена більш ніж 10 000 графічних процесорів Nvidia A100.

Дебютна модель DeepSeek, випущена в листопаді 2023 року, відразу продемонструвала продуктивність на рівні GPT-4 і була надана безоплатно для дослідників і комерційного використання. До травня 2024 року запущено DeepSeek-V2, водночас конкурентна цінова політика компанії змусила навіть таких гігантів, як ByteDance, Tencent, Baidu та Alibaba, знизити ціни на свої ШІ-рішення. У підсумку DeepSeek вдалося зберегти прибутковість, тоді як конкуренти зазнавали збитків.

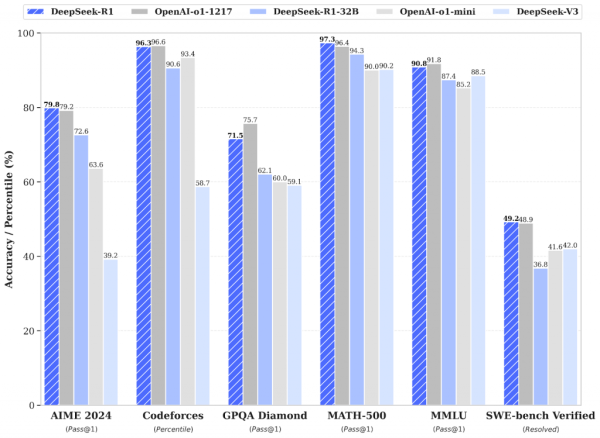

У грудні 2024 року з’явилася модель DeepSeek-V3, чиї показники в тестах перевершили останні розробки OpenAI й Anthropic. На її основі компанія створила DeepSeek-R1 та її похідні, які й лягли в основу гучного сервісу.

Порівняння продуктивності моделей DeepSeek з моделями OpenAI в різних тестах. Джерело: DeepSeek.

Головна перевага нової моделі — безпрецедентно низька вартість використання. За обробку мільйона токенів DeepSeek бере всього $2,19, тоді як OpenAI за аналогічний обсяг стягує $60.

За лаштунками прориву: як влаштований DeepSeek-R1

Згідно з опублікованим дослідженням, в основі моделі DeepSeek-R1 лежать методи навчання з підкріпленням і «холодного старту». Це дало змогу досягти виняткової продуктивності в таких галузях, як математичні обчислення, програмування і логічне мислення.

Ключовою особливістю моделі став підхід Chain of Thought, що дає змогу розбивати складні завдання на послідовні кроки, імітуючи людське мислення. Система аналізує завдання, розділяє його на етапи та перевіряє кожен крок на наявність помилок перед формуванням остаточної відповіді.

Технічна реалізація вражає своєю ефективністю. DeepSeek-R1 навчалася на системі з 2048 прискорювачів Nvidia H800, витративши близько 2,788 млн годин роботи GPU. Оптимізація процесу досягається шляхом застосування змішаної точності FP8 і технології Multi-Token Prediction, що істотно знижує вимоги до обладнання.

Архітектура моделі включає 671 млрд параметрів. Але унікальність методу в тому, що за один прохід активується тільки 37 млрд із них. Використання «суміші експертів» (Mixture of Experts) забезпечує масштабованість без пропорційного зростання обчислювальних витрат.

На окрему увагу заслуговує інноваційний метод Group Relative Policy Optimization (GRPO). Він дає змогу навчати модель без використання критика, що значно підвищує ефективність процесу.

Як зазначив старший менеджер із досліджень у Nvidia Джим Фан, це нагадує прорив AlphaZero від Google DeepMind, яка навчилася грати в го і шахи «без попереднього наслідування людських гросмейстерських ходів». За його словами, це «найважливіший висновок із дослідницької статті».

We are living in a timeline where a non-US company is keeping the original mission of OpenAI alive – truly open, frontier research that empowers all. It makes no sense. The most entertaining outcome is the most likely.

DeepSeek-R1 not only open-sources a barrage of models but… pic.twitter.com/M7eZnEmCOY

— Jim Fan (@DrJimFan) January 20, 2025

Новий підхід до навчання мовних моделей

Особливо цікавий підхід DeepSeek до навчання. На відміну від інших провідних LLM, R1 не проходила традиційну «попередню підготовку» на даних з людською розміткою. Дослідники знайшли спосіб, що дозволяє моделі розвивати власні здібності до міркування практично з нуля.

«Замість того, щоб явно навчати модель того, як розв’язувати проблеми, ми просто надаємо їй правильні стимули, і вона автономно розробляє передові стратегії», — йдеться в дослідженні.

Модель також представляє нову парадигму в розвитку ШІ: замість простого нарощування обчислювальних потужностей для навчання, акцент робиться на тому, скільки часу і ресурсів модель витрачає на обдумування відповіді перед її генерацією. Це масштабування «обчислень у тестовий час» відрізняє новий клас «моделей, що міркують» на кшталт DeepSeek R1 і OpenAI-o1 від їхніх попередників.

Критичний погляд на прорив DeepSeek

Успіх DeepSeek викликає чимало запитань у професійній спільноті. Гендиректор Scale AI Олександр Ванг, стверджує, що компанія має у своєму розпорядженні 50 000 чипів Nvidia H100, що прямо суперечить американським експортним обмеженням.

«Наскільки я розумію, у DeepSeek встановлено 50 тисяч H100 […]. Вони не можуть говорити про них [публічно], тому що це суперечить експортному контролю США», — сказав Ванг.

З огляду на те, що після введення обмежень вартість контрабандних H100 у Китаї злетіла до $23 000-30 000, такий кластер обійшовся б у $1-1,5 млрд.

Аналітики Bernstein ставлять під сумнів заявлену вартість навчання моделі V3 в $5,6 млн і відзначають відсутність даних про витрати на розробку R1. На думку експерта Peel Hunt Дамінду Джаявіра, публічні цифри відображають тільки вартість GPU-годин, ігноруючи інші істотні витрати.

«Вона була навчена менш ніж за 3 млн годин роботи GPU, що відповідає вартості навчання трохи більше ніж $5 млн. Для порівняння, за оцінками аналітиків, навчання останньої великої моделі ШІ компанії Meta обійшлося в $60-70 млн», — сказав Джаявіра.

Політичний аспект також викликає побоювання. Участь засновника DeepSeek Лян Веньфена в закритому симпозіумі під головуванням прем’єр-міністра Китаю Лі Цяна може вказувати на стратегічну роль компанії в подоланні експортних обмежень і досягненні технологічної незалежності КНР.

«Існує велика ймовірність того, що DeepSeek і багато інших великих китайських компаній підтримуються урядом Китаю не тільки в грошовому вираженні», — заявив Едуард Харріс, технічний директор Gladstone AI, яка тісно співпрацює з урядом США.

Не можна не відзначити й вбудовані механізми цензури в API-версії R1, особливо щодо політично чутливих для КНР тем. Модель відмовляється обговорювати події на площі Тяньаньмень, права людини в Китаї або статус Тайваню, замінюючи згенеровані відповіді стандартними ухильними формулюваннями.

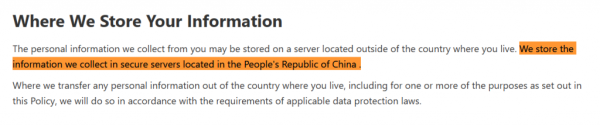

Окремі побоювання викликає питання конфіденційності даних. Згідно з політикою DeepSeek, особиста інформація користувачів зберігається на серверах у КНР, що може створити для компанії проблеми, аналогічні тим, з якими зіткнувся TikTok. Особливо гострим це питання може стати на американському ринку, де регулятори вже виявили підвищену увагу до китайських технологічних компаній у контексті захисту персональних даних.

Фрагмент політики конфіденційності DeepSeek. Джерело: DeepSeek.

Майбутнє мовних моделей після DeepSeek

Попри суперечності, досягнення DeepSeek не можна недооцінювати. Результати тестування показують, що модель R1 дійсно перевершує американські аналоги за багатьма параметрами. Як зазначив Олександр Ванг, це «тривожний дзвінок для Америки», що вимагає прискорення інновацій та посилення експортного контролю над критично важливими компонентами.

DeepSeek is a wake up call for America, but it doesn’t change the strategy:

– USA must out-innovate &race faster, as we have done in the entire history of AI

– Tighten export controls on chips so that we can maintain future leadsEvery major breakthrough in AI has been American

— Alexandr Wang (@alexandr_wang) January 26, 2025

Хоча OpenAI поки що зберігає лідерство в галузі, поява DeepSeek істотно змінює розклад сил на ринку ШІ-моделей та інфраструктури. Якщо офіційні дані відповідають дійсності, китайській компанії вдалося створити конкурентоспроможне рішення з істотно меншими витратами завдяки інноваційним підходам і оптимізації. Це ставить під сумнів стратегію простого нарощування обчислювальних потужностей, якої дотримуються багато учасників ринку.

Інтерес до технологій DeepSeek зростає: Meta вже створила чотири «військових кабінети» для аналізу китайських моделей, прагнучи застосувати отримані знання в розвитку власної екосистеми Llama з відкритим вихідним кодом.

Деякі експерти вбачають в успіху DeepSeek не стільки загрозу технологічному домінуванню США, скільки ознаку формування багатополярного світу ШІ. Як зазначив колишній співробітник відділу політики OpenAI Майлз Брундадж:

«Китай однаково заведе власний суперінтеллект (и) не більш ніж на рік пізніше за США, якщо не станеться війни. Тож якщо ви не хочете (у буквальному сенсі) війни, вам потрібно мати бачення того, як орієнтуватися в багатополярних результатах розвитку ШІ».

Схоже, ми спостерігаємо початок нової ери в розвитку штучного інтелекту, де ефективність і оптимізація можуть виявитися важливішими за чисту обчислювальну потужність.